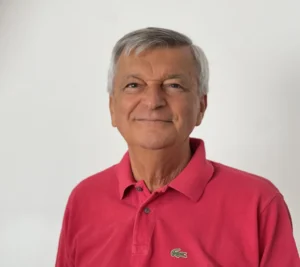

Intelligenza artificiale, ne parliamo con l’avv. Guido Scorza

Verso il totalitarismo tecnologico: Intelligenza Artificiale, gabbie digitali, robotica, smart city, cyberuomo, nanotecnologie… ne parliamo con l’avvocato Guido Scorza, componente del Collegio del Garante per la protezione dei dati personali.

Possiamo fidarci dell’I.A. o il suo utilizzo in diversi settori per le sue capacità di apprendimento automatico, elaborazione del linguaggio, riconoscimento d’immagini e molte altre funzioni, minaccia la nostra sicurezza?

L’AI è uno strumento potente che può migliorare la sicurezza e l’efficienza, ma presenta rischi se usata senza controllo. Infatti, il problema non è l’I.A. in sé, ma come essa viene sviluppata, regolata e impiegata. Se gestita con trasparenza, sicurezza e supervisione umana, può essere affidabile. Tuttavia, senza regole chiare, può amplificare minacce come cyber attacchi, deepfake e violazioni della privacy. Serve un equilibrio tra innovazione e sicurezza per poterla sfruttare senza pericoli tenendo sempre al centro dell’attenzione i diritti e le libertà personali.

I dati possono essere rubati, modificati o utilizzati scorrettamente?

Sì, i dati possono essere rubati, modificati o usati scorrettamente se non vengono protetti adeguatamente. Le principali minacce sono attacchi informatici, accessi non autorizzati ed errori umani. Per ridurre i rischi è necessario adottare idonee misure di sicurezza (come crittografia, controlli di accesso e monitoraggio continuo) e soprattutto fare in modo che gli utenti siano realmente consapevoli non solo delle potenzialità, ma anche dei rischi delle nuove tecnologie.

Si può arrivare con false immagini o video a manipolare l’opinione pubblica?

Certamente, false immagini e video, come i deepfake, possono manipolare l’opinione pubblica diffondendo disinformazione. Se ben realizzati, possono ingannare le persone, influenzare le elezioni, rovinare la reputazione etc. Per difendersi, servono educazione digitale, verifica delle fonti e strumenti tecnologici per rilevare i falsi.

Preti virtuali in forma di ologramma o dalle sembianze robotiche potrebbero celebrare la S. Messa, confessare e predicare?

Mi risulta che in alcuni Paesi esistano già esperimenti con preti virtuali, sotto forma di ologrammi o robot, che predicano e guidano momenti di preghiera. Effettivamente la tecnologia potrebbe servire a supportare la fede, rispondere a domande religiose e diffondere insegnamenti ad esempio per chi non ha la possibilità di frequentare una comunità religiosa oppure in contesti dove mancano sacerdoti, anche se soprattutto in questi contesti il rapporto umano mi sembra essenziale.

Intelligenza Artificiale a scuola: utile o pericolosa? Come cambia l’insegnamento?

L’Intelligenza Artificiale a scuola può essere sia utile che rischiosa; utile perché in grado di personalizzare l’apprendimento, supportare gli insegnanti e rendere le lezioni più interattive; rischiosa perché può ridurre il pensiero critico e creare dipendenza se usata passivamente. L’insegnamento con l’I.A. diventa più interattivo e personalizzato, potendosi maggiormente adattare ai bisogni degli studenti. Ciò sarà possibile ovviamente solo se anche gli insegnanti sapranno utilizzare correttamente le nuove tecnologie cosi da guidare gli studenti nell’uso critico delle stesse.

Quale è il futuro del lavoro prospettato dal World Economic Forum?

Il World Economic Forum (“Future of Jobs Report 2025″ del World Economic Forum, pubblicato il 7 gennaio 2025”) prevede un futuro sempre più influenzato dall’automazione e dall’Intelligenza Artificiale, che sostituirà alcuni lavori tradizionali automatizzando compiti ripetitivi, e creandone di nuovi in settori tecnologici, creativi e di gestione. Crescerà la domanda di competenze digitali e sarà sempre più essenziale, per adattarsi ai cambiamenti del mercato del lavoro, come peraltro già accaduto in passato, la formazione continua a tutti i livelli.

L’I.A. potrebbe fare discriminazione se i dati di input sono influenzati da pregiudizi umani?

Purtroppo conosciamo molteplici episodi di discriminazioni generate da algoritmi viziati da bias cognitivi, come accade in alcuni Stati USA in cui l’I.A. viene utilizzata per finalità di giustizia predittiva. Ciò dipende dal fatto che i modelli apprendono dai dati forniti e possono riflettere e amplificare stereotipi esistenti. Per evitare questo problema è fondamentale usare dati equilibrati, migliorare gli algoritmi di controllo e applicare verifiche etiche nell’uso dell’I.A.

L’I.A. avrà anche un impatto ambientale?

L’A.I ha un impatto ambientale, soprattutto per il consumo energetico dei data center e l’uso di risorse per l’addestramento dei modelli. Le operazioni di calcolo intensive richiedono molta elettricità e tuttavia, grazie ad esse si potranno forse trovare nuove soluzioni in grado di ottimizzare consumi energetici, migliorando la gestione delle risorse e supportando soluzioni sostenibili.

Cinzia Notaro